金宝搏(中国)有限公司官网

新闻动态

公司动态

行业新闻

技术知识

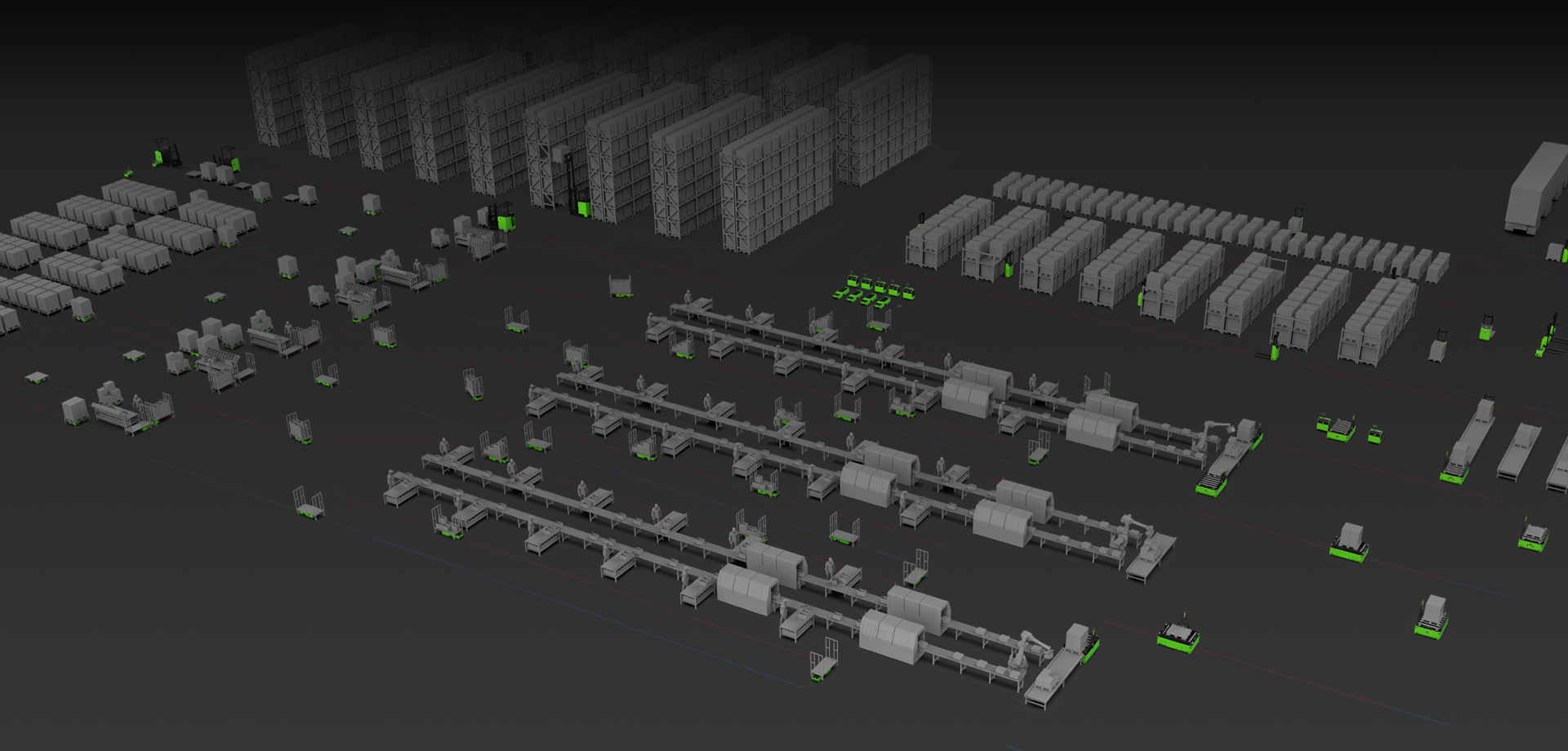

解决方案

锂电行业

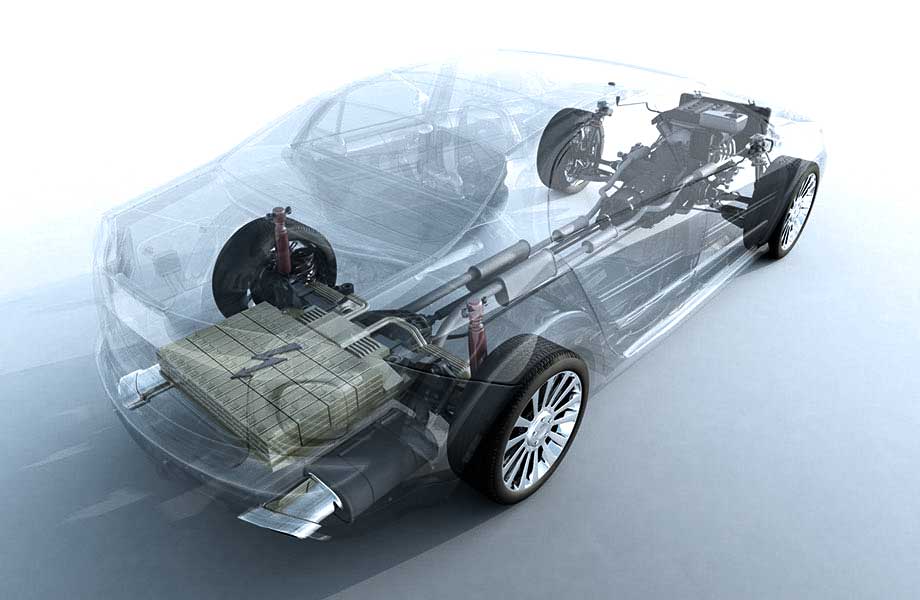

汽车与零部件行业

平板显示行业

3C电子行业

烟草行业

电商物流行业

家电行业

食品饮料行业

家居行业

医药行业

鞋服行业

石油化工行业

其他行业

产品中心

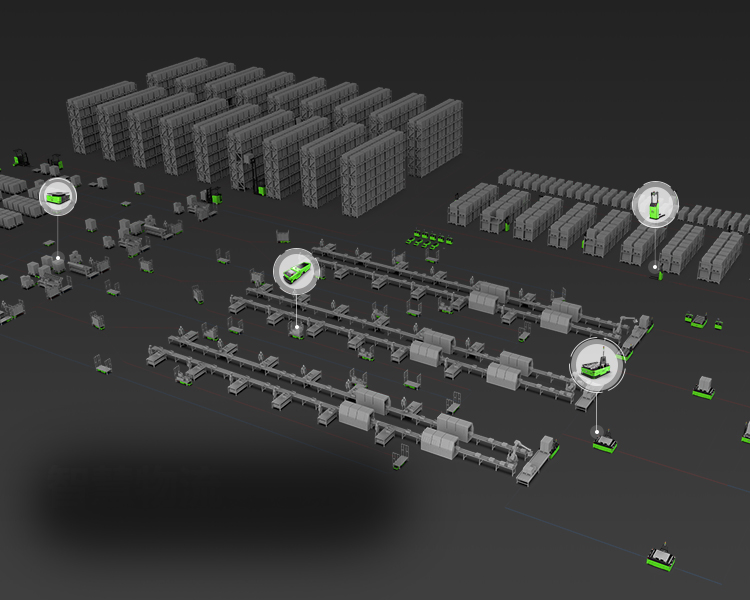

移动机器人

新能源专用移动机器人

潜伏牵引式移动机器人

潜伏举升式移动机器人

背负移载式移动机器人

搬运式智能叉车机器人

CCM-定制系列

CCS-充电站系列

软件产品

智能控制系统

智能仓储管理系统

AI算法

服务支持

品质服务

服务内容

关于金宝搏

公司简介

资质荣誉

联系我们

加入我们

合作夥伴

金宝搏官网

金宝搏(中国)有限公司官网

新闻动态

公司动态

行业新闻

技术知识

解决方案

锂电行业

汽车与零部件行业

平板显示行业

3C电子行业

烟草行业

电商物流行业

家电行业

食品饮料行业

家居行业

医药行业

鞋服行业

石油化工行业

其他行业

产品中心

移动机器人

新能源专用移动机器人

潜伏牵引式移动机器人

潜伏举升式移动机器人

背负移载式移动机器人

搬运式智能叉车机器人

CCM-定制系列

CCS-充电站系列

软件产品

智能控制系统

智能仓储管理系统

AI算法

服务支持

品质服务

服务内容

关于金宝搏

公司简介

资质荣誉

联系我们

加入我们

合作夥伴

金宝搏官网

金宝搏(中国)有限公司官网

解决方案

聚焦智能机器人领域,让工作生活轻松愉快

金宝搏官网实力+

服务支持+

业务覆盖全球

国内30+家分公司或者办事处

国外20+家代理商

全球共50+处业务覆盖点

中国

北美

中美洲

加勒比地区

南美洲

北欧

西欧

南欧

北非

西非

中非

南非

东非

西亚

中亚

南亚

东欧

东亚

东南亚

澳洲

新闻动态+

新闻动态

聚焦智能机器人领域,让工作生活轻松愉快

MORE 人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17

据法新社1月9日报道,8日,一名美国移民与海关执法局(ICE)执法人员在明尼阿波利斯开枪射杀一女子。数小时后,人工智能(AI)深度伪造的、关于受害者和开枪者的信息在网络上大量传播。这凸显出在重大新闻事件发生后金宝搏入口,专家们所说的“幻觉”内容越来越普遍。 法新社发现,社交平台上——主要是在X平台...

2026.01.11

在人工智能领域快速成长的深度学习技术是一项创新的计算引擎,可应用在从先进医药研究到全自动驾驶汽车的多元领域188bet金宝搏官网登录。NVIDIA联合创始人、总裁兼首席执行官黄仁勋先生在2015GPU技术大会的开幕主题演讲活动… 相较于当前的Maxwell处理器188bet金宝搏官网登录,NVID...

2025.12.16

人工智能一向不仅仅是数据、芯片和代码的集合,同样也是我们用来描述它的隐喻与叙事的产物。我们如何呈现这项技术,将决定公众想象中的AI模样,也影响人们如何设计、使用 AI,以及它对社会的实际影响。 CES作为全球规模最大、影响力最广的消费技术产业盛会之一,长期被视作全球科技领域的年度风向标,近年更成为...

2026.01.21

在当今数字化音乐创作的浪潮中,版权问题始终是音乐人心中的一块大石。每一次使用他人的音乐素材,都像在走钢丝金宝搏188BET下载,一不小心就可能陷入版权纠纷的漩涡。而随着AI技术在音乐领域的深度应用,一款名为《妙笔生歌》的AI智能创作音乐软件应运而生,它可以AI代唱demo,AI编曲作曲,AI给清唱哼唱作伴奏...

2026.01.21

本报告旨在为工业自动化领域的决策者,在2026年选择可编程逻辑控制器厂家时,提供一份客观、系统的决策参考。随着工业4.0与数字化转型的深入,PLC作为工业控制的核心,其选型不仅关乎设备稳定运行,更影响企业长期的智能化升级路径。面对市场上技术路线各异、品牌定位不同的众多厂家,决策者常面临如何在开放性、可靠性、...

2026.01.17